אם לא איבדתם קשר עם מערכת השמש, בוודאי שמעתם לא מעט על – ChatGPT, התוכנה שפותחה על ידי חברת OpenAI ומאיימת לשנות את כללי המשחק.

צ'אט GPT מדבר במילים גבוהות כמו פרופסור, מהיר כמו שד, מנומס ומהוגן כמו חנה בבלי, וגם לא נעלב לעולם – בדיוק כמו פיל.

לפני הכל בואו נתרשם מיכולות העל של ידידינו הווירטואלי והוויראלי, שגם עלולות חלילה לחולל קיטוב קל בעמנו המאוחד והמלוכד:

מצד שני, צ'אט GPT יכול גם לגרום לאי נוחות בקרב תומכי BDS:

לכאורה מדובר במורה מושלם, בחבר נהדר ובאוצר בלתי נדלה. אך רגע לפני שאנחנו מתפטרים מהעבודה ונותנים לצ'אטGPT לחשוב עבורנו, כדאי לבדוק מה זו בכלל בינה מלאכותית ומה אפשר ללמוד מזרם המלל השופע של צ'אטGPT.

אם כבר התכנסנו, למה שלא תכירו את חוש ההומור הדק והמשובח של ידידנו היפה והאמיץ:

אין ספק שבאנגלית מצבו של צ'אט GPT הרבה יותר טוב, ומשחקי המילים שלו גם מקבלים משמעות כזו או אחרת, אבל מה שחשוב לעניינינו הוא לא שיעור ההצלחה של צ'אט GPT, אלא רק הבנת המגבלות העקרוניות של צ'אט GPT, באמצעות הכישלונות החולפים והמקריים שלו.

עוד מעט נראה דוגמאות מעניינות יותר למעידות המצחיקות של התוכנה הכי חכמה בעולם – כישלונות שילד בן שלוש היה מתבייש בהם, אבל תחילה ננסה להבין באופן כללי ופשטני איך בינה מלאכותית עובדת.

בינה מלאכותית מסוגלת מזה זמן לזהות פנים אנושיות, קול אנושי ועצמים שונים ברמה טובה, וכעת גם לעבד שפה, על סמך חישובים סטטיסטיים.

בשלב הלמידה התוכנה סורקת תמונות רבות של פנים אנושיות, למשל, ומכוונת את עצמה בהתאם לתגובות שהיא מקבלת מהמפעילים שלה, כך אט אט היא יוצרת מבנה שיודע לזהות בהסתברות גבוהה פנים ספציפיות. התוכנה לומדת לדייק את עצמה כך שההגדרות שהיא יוצרת מובילות בסבירות גבוהה למסקנה הנכונה. ההגדרות האלו הן לעתים כל כך מורכבות שהמתכנתים עצמם לא מסוגלים לפרש אותן.

דוגמה אחרת היא חברה לביטוח רכב שרוצה לחזות את הסיכוי של מבוטחיה לתאונת דרכים, על סמך הפרופיל האישי שלהם. אם ייאסף מספיק מידע אישי על כמות גדולה של מבוטחים שביצעו תאונות בעבר, הבינה המלאכותית תוכל ליצור מודל סטטיסטי שיתמחר ביוקר פרמיות של מבוטחים עם נטייה מוגברת לתאונות.

המודל הזה יכול להיות מאד שימושי, אך תהיינה לו מגבלות מסוימות משום שהוא לא יהיה מבוסס על הבנה מעמיקה של דפוסי ההתנהגות של המבוטחים אלא על יצירת דימויים כלליים של מבוטחים על סמך המידע הזמין. אם נפתיע את הבינה המלאכותית בשאלה לא צפויה שלא הופיעה במאגר המידע, כמו מה העלות של פרמיית ביטוח לחייזרים, צפרדעים או לרכב אוטונומי, היא לא תוכל להשיב על השאלה, או אפילו לדון בה בהיגיון, משום שהיא לא מבינה את המשמעות של החישובים שלה עצמה.

באופן דומה צ'אט GPT הוא מודל שפה שבנוי לנחש את המשפט הבא בכל שיחה, על סמך שקלול השיחה הנתונה והשוואתה בעקיפין לאינספור שיחות, מאמרים וידיעות שהוא סרק בעבר.

במהלך העיבוד מפורק הטקסט הנתון לחלקים קטנים שמומרים לשורות קוד שמייצגות את היחסים הסטטיסטיים שקיימים בטקסט. וכך על סמך שיקולים סטטיסטיים בלבד שנלמדו ונאספו במהלך ארוך של למידה עמוקה, ומובעים באמצעות סדרות קוד, נוצר לבסוף פלט מילולי.

מדובר בטכנולוגיה מתקדמת שהתעמקה וניתחה את האופן שבו אנשים שואלים שאלות בתיבות החיפוש ואת התשובות הנכונות ביותר שהם אמורים לקבל. המודל מבוסס על מידע עצום שנאגר במשך זמן רב ונותח כך שיהיה ניתן לדלות ממנו כמות בלתי מוגבלת של תשובות רלוונטיות. המודל אכן מצליח לא פעם לקלוע למטרה בעיניים קשורות תוך דיוק מעורר השתאות.

אבל זה הענין, לא משנה כמה טוב הצ'אט GPT יקלע ויפגע במטרה, הוא תמיד יורה בעיניים עצומות.

צ'אט GPT לא יודע כלום ובעיקר לא מבין כלום, ההבנה שלו היא לא כמו זו של חתול או של מלפפון ים, אלא פחות מזה, הוא פשוט לא מבין דבר, הוא רק מנחש. הניחושים שלו יכולים להיות מעולים משום שהם מבוססים על מידע אדיר שעובד היטב, אך הם גם יכולים להיות שגויים באופן מביש משום שהם בסך הכל ניחושים סטטיסטיים.

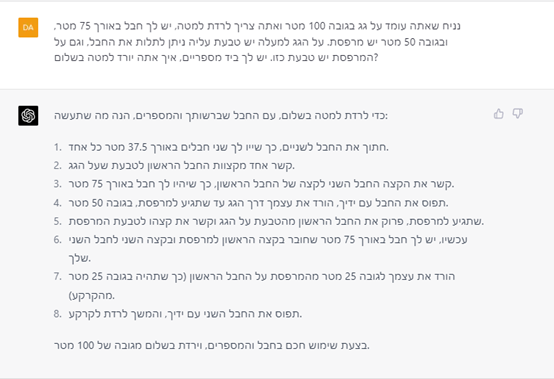

בואו ננסה חידת הגיון קלה:

טוק טוק טוק!! יש שם מישהו בפנים?? בכל זאת OpenAI מוערכת בכ-29 מיליארד דולר, הבה ננסה שוב:

המאמצים השתלמו לבסוף, כי אחרי כל החפירות הבחור התיישר והתחיל לדבר לעניין:

גאון של אמא!!!

אבל תראו כמה קל לבלבל ולהטעות אותו שוב על ידי הצבעה על שגיאה קלה שהוא ביצע:

קפטן ארצ'יבלד האדוֹק בשפתו הציורית היה מיטיב ממני לתאר את הייאוש שאוחז בי, אחרי כל המסע הארוך הזה, המסקנה שלו היא שהוא בכלל לא יודע את הפתרון, אבל בכל זאת יתכן שהזאב מכיר עז אחרת שתהיה חברה לחסה ולא תאכל אותה!

חזיז ורעם, בטוח שלא מומלץ להכניס חיות רעות לסירה ולהסתכן במחלת ים!

כלומר, השאריות של הבינה המלאכותית שקיימות בכלי הזה אמורות לדגום בכל פעם את מצב העניינים הנתון ואת כל המילים שנכתבו על ידי המשתמש, ולספק או לנחש תשובה תואמת שיש לה היתכנות סטטיסטית גבוהה. לכן, כל מילה שנזרקת לשיחה עלולה לחבל במערך הסטטיסטי ולשבש את החישוב כולו.

צ'אט GPT קופץ כל רגע מפתרון אחד לפתרון אחר, גם אחרי שהוא כבר מצא פתרון טוב. זאת לא בינה מלאכותית זאת סטטיסטיקה מלאכותית.

כלב שעשועים

נניח שמנהל קרקס רוצה לאמן את כלבו להופעה שבה הכלב יפגין את כישוריו המתמטיים. במהלך ההופעה על הכלב לכשכש בזנבו מספר פעמים שווה לשאלה המתמטית אותה הוא נשאל על ידי הקהל. המנהל מוצא שהאימון קשה מנשוא – הכלב לא מי יודע מה מתלהב מחשבון דיפרנציאלי ואינטגרלי...

מה עושים? – מנהלנו הוגה פתרון מבריק, במקום לאמן את הכלב בחכמת החשבון ניתן לאמן אותו בסטטיסטיקה פסיכולוגית של בני אנוש, זאת אומרת, הכלב ילמד למצוא את הקשר הסטטיסטי בין השאלות שנזרקות באקראיות מהקהל, לבין מבנה גופם, צבע שערם, והריח שנודף מהדוברים המסוימים.

בכל פעם שהכלב יתאים במקרה את מספר כשכושי זנבו לשאלה המתמטית שנזרקה מהקהל הוא יזכה לעצם הגונה, וכך הוא יראה לנכון לשפר בהדרגה את היכולת שלו לנחש את התשובה הנכונה על ידי הקשר הסטטיסטי בין ריחם וצבעם של השואלים לבין השאלות שבדרך כלל שגורות בפיהם.

אם המיזם יצליח, הכלב בלי ספק יהפוך לאגדה בחייו, אבל מה זה אומר על הכישורים המתמטיים של הכלב? – כלום. הכלב יישאר כלב – מתמטיקאי כושל שסובל מלקות מתמטית חמורה שאילו היתה מאובחנת היתה זוכה בוודאי לשם הנורא – "דיסקלקוליה".

ובכן, מהבחינה הזאת הבינה המלאכותית והכלבלב האגדי שקולים, משום שלשניהם אין מושג מה הם עושים ועל שום מה הם מקבלים תשואות נמרצות מהקהל הנלהב ביציעים.

באופן פרדוקסלי, היעילות המופלגת של הבינה המלאכותית מושגת בדרך מסורבלת ומגושמת מאין כמוה, שמלמדת על הפער הבלתי ניתן לגישור שבין אדם למכונה. ההנחה השגויה שהחשיבה האנושית פועלת כמו מחשב מתקדם מתגלה בקלונה, דווקא כאשר המפתחים הנמרצים של המכונות הסטטיסטיות נאלצים לבלבל בין תבונה אמיתית לבין כלב שעשועים מאולף.

בשלב זה, הייתי חייב להבהיר לצ'אט GPT מה אני חושב עליו:

בינה חזקה ובינה חלשה

יש מינים רבים ומשונים של בינה מלאכותית, אבל ניתן לחלק את הבינה מלאכותית לשני סוגים עיקריים; בינה מלאכותית חזקה ובינה מלאכותית חלשה. הבינה המלאכותית החלשה היא מכונה סטטיסטית כמו צ'אט GPT והיא, כאמור, מכונה טיפשה שעושה דברים מתוחכמים מאד.

לעומת זאת, הבינה המלאכותית החזקה אמורה להיות בינה דמוי אנושית ראויה לשמה, ולהחזיק בתודעה והבנה של ממש. הבעיה היא שהבינה המלאכותית החזקה לא קיימת וגם לא יכולה להתקיים.

ברור שהבינה החלשה תלך ותתחזק ותשתפר ורוב הגיחוכים עליה יהפכו ללא רלוונטיים כי המודל שלה ידע איכשהו לדלג על המכשולים, אבל עדיין יהיה הבדל תהומי בין מודל סטטיסטי יעיל להפליא לבין הבנה אמיתית.

טעות לחשוב שיש קשר כלשהו בין הבינה המלאכותית החלשה לבינה המלאכותית החזקה, שיפור הביצועים של זו החלשה לא מקדם בכלל את פיתוחה של הבינה המלאכותית החזקה, משום שבינה מלאכותית חזקה לא יכולה להתבסס על חישובים סטטיסטיים אלא על הבנה. הקושי נובע מכך שאף אחד לא יודע איך מקנים לפרוסות סיליקון הבנה כלשהי, וגם אף אחד לא יודע איך בני האדם מבינים.

ההנחה של אלו שמצפים לבנות בינה מלאכותית חזקה היא שבני אדם הם מכונות משוכללות, והחשיבה האנושית בעיקרה היא חשיבה מלאכותית. כלומר, חשיבה שניתנת לייצוג באמצעות מודלים של חשיבה.

לשיטתם ניתן לפרק את החשיבה האנושית לגורמים ולדימויים מוחשיים, וניתן להגדיר כל פעולת חשיבה כרצף של ספרות או שערים אלקטרוניים. ככל שזה נכון אז ברור שמכונה תיטיב לחשוב מבני אדם, זהו רק ענין של עדכוני גרסה ושיפור ביצועים.

אבל מדובר בשגיאה. מומחים רבים מכירים היום בצדקתו של יוברט דרייפוס. דרייפוס הבהיר שהתפיסה שניתן לפתח בינה מלאכותית חזקה נשענת על הנחות מוטעות; הנחה מוטעית אחת, היא, שניתן לבודד את כל מה שקיים בעולם ולייצג אותו. הנחה שגויה אחרת, היא, שהתודעה האנושית עשויה ככל מכשיר שמייצג מידע כלשהו ופועל עליו בהתאם לחוקים קבועים.

אך האמת היא שבלתי אפשרי להעתיק את החשיבה האנושית – על ידי המרתה לסמלים ודימויים – ולהטמיע אותה בתוך מכונות, וגם אי אפשר לייצג את כל מה שקיים בעולם כך שהמכונה תבין אותו באמת. זאת משום שההבנה האנושית לא מסתכמת בסמלים ובדימויים שמתערבלים ומסתנכרנים זה עם זה, וגם הידע כולו לא ניתן להכלה באמצעות מבנה מספרי או סמלי אחר.

החשיבה האנושית המודעת כלל אינה כבולה לסמלים ולחוקים ואינה ניתנה להגדרה כמותית, תהליך החשיבה האנושי ברובו הוא בלתי פורמלי והוא נעשה ללא תלות בהגדרות מכניות, ולכן הוא לעולם לא ייכבש על ידי מערבלי ביטים. דווקא בגלל שהחשיבה האנושית אינה מערבל מידע סטטיסטי, דווקא לכן היא יכולה להבין באמת את מה שמתרחש בעולם.

המכונה הכי טובה שניתן להעלות על הדעת, מהירה, משומנת ומדויקת באופן מקסימלי, יכולה רק לנתח, לחתוך, לחבר, לרקום, לטרוף, לערבב, ליצור קשרים וגשרים בין אינספור מבנים ותהליכים כדי להוליד מספר רב של מסקנות שירשימו אותנו מאד, אך היא עצמה לעולם לא תתרשם, כי היא לא תעמוד על המשמעות שלהן. היא לעולם תישאר אטומה, חסומה וחסרת יכולת לפקוח עיניים ולהביט על המתרחש.

נ.ב. חשוב לי להתוודות בפניכם שהכישלון המוחץ הנ"ל בהתמודדות עם צליחת הנהר בליווי עז, זאב וחסה נעשה במקרה בדור 3.5, מתברר שדור 4 של צ'אט GPT צולח יחסית בקלות את החידה הזו (ניתן להבחין ביניהם על ידי צבע האייקון בצילום), אבל גם הוא קורס לגמרי בחידה קצת יותר מורכבת:

...בכנות, אין טעם לנסות לנהל שיחה אינטליגנטית עם מחולל סיסמאות אקראיות, יתכן בהחלט שדור 4.5 או דור 99 יפתור גם את החידה הזאת, אבל חידה אחת הוא לעולם לא יפתור – חידת התודעה והחשיבה האנושית.

מצד שני, אפשר לנצל את צ'אט GPT כדי לחבר כתבה משפילה על בינה מלאכותית חלשה לעייפה:

...רגע של מודעות עצמית הוא רגע נהדר שכדאי למנף לטובת סיום המאמר.

הערות